2023年4月26日,人文科学研究院在校图书馆501学术沙龙举办了“没有‘面目’的聊天者:从心理语言学的角度反观ChatGPT”的工作坊,活动由人文科学研究院祁玥老师发起、主持,邀请了伦敦大学学院(UCL)脑科学学院实验心理学系的博士后研究员张烨,为同学们从心理语言学的角度展开主题分享。

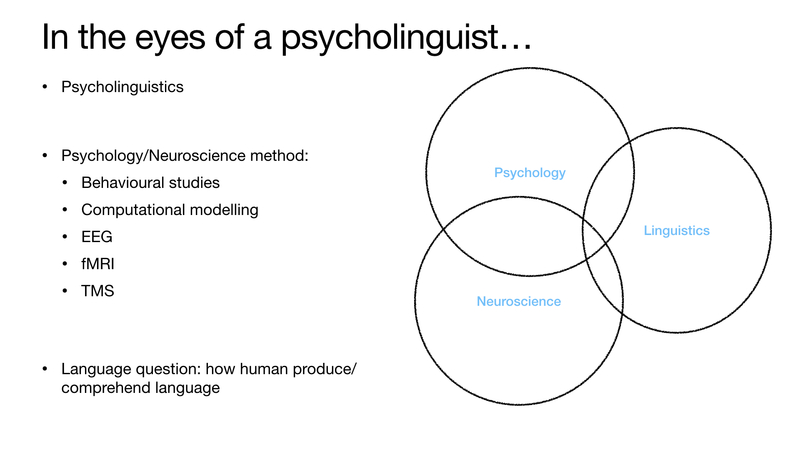

张烨博士首先简单介绍了心理语言学(psycholinguistics)这一语言学、心理学与神经科学的交叉领域,并讲解行为研究(behavioural studies)、计算建模(computational modelling)、脑电图分析(EEG)、功能性磁共振成像(fMRI)、经颅磁刺激(TMS)等不同学科的方法何以有效地帮助学者展开语言处理和语言学的研究。

接着由最近引发热议的ChatGPT,带领同学们思考与GPT对话和与人类对话的区别,指出GPT是一个没有“面目”的聊天者,而实际上语言的使用和处理是多模态的(multimodal),信息会通过多种模态传达,包括声音、视觉、动作、口型、目光等。因此在接下来的讨论中,张烨博士以手势(gesture)、口型(mouth movement)和眼神(gaze)为例,通过多项实验和数据分析,向大家具体展示多模态信息对语言处理的重要性。

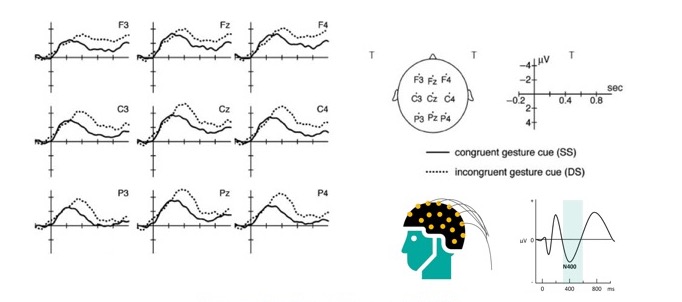

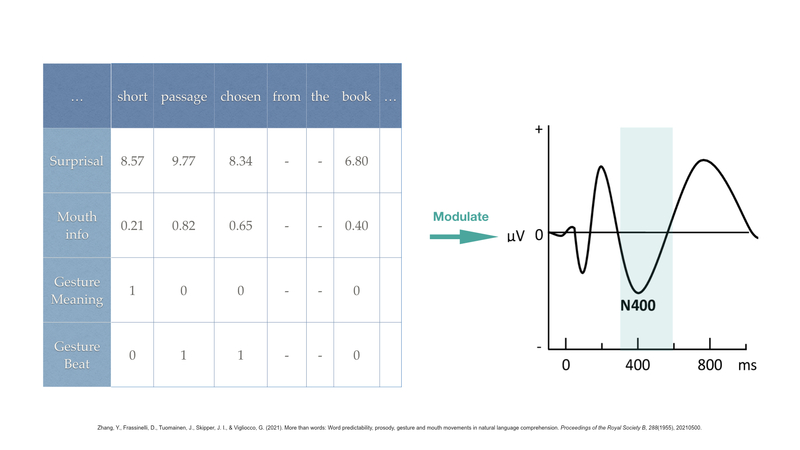

语言学家发现,全球各地语言虽异彩纷呈,但没有一种语言不含手势(gesture)。它不仅参与语言演化,预示使用主体的语言习得,影响人的记忆,还能有效地消除信息传递和接收中的歧义。例如实验中,将声音模态与视觉模态结合,通过EEG方法观测人脑电波与事件相关的电位变化,通过N400数值看出,处理歧义句时当语言与手势吻合时N400绝对值更小,意味着手势可以辅助排除歧义,使得语言处理更容易。

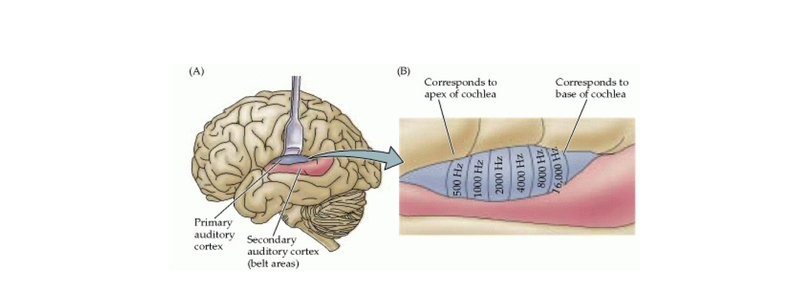

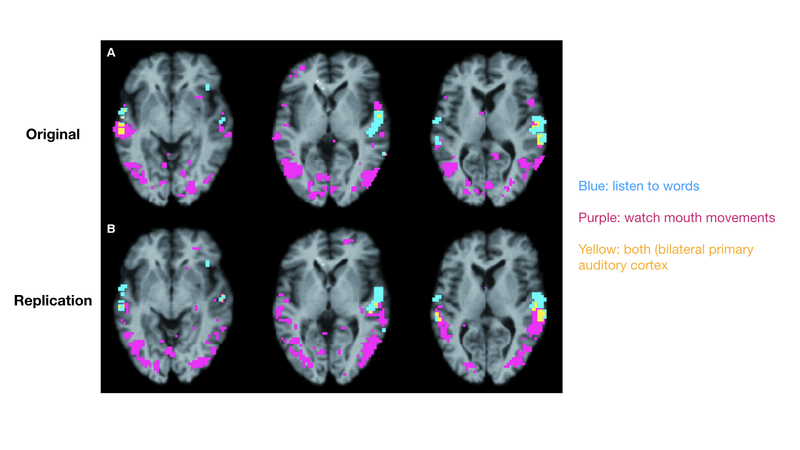

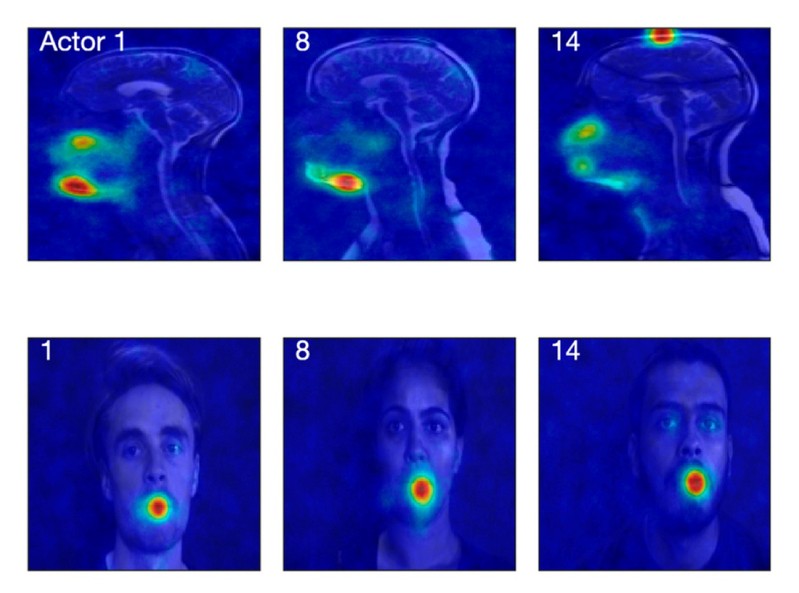

而口型(mouth movement)在语言的认知与理解过程中也发挥着重要作用。通过fMRI方法观测大脑被激活的区域,可以发现大脑会从口型中获得声音上的信息。

同时仅仅利用包括口型在内的面部运动(facial movements)信息重建发声器官的MRI图像,可以很高程度地拟合还原真实发声时声道运动(vocal track movement)。表明声带的大部分信息其实已经通过面部信息传达,且口部尤为重要。

此外,实验表明,眼神(gaze)对反应时长、交流速度、专注度都有影响,激活情绪及其处理,促进大脑的协作。包括眨眼(blinks)的暗示作用、其长短对说话者下意识改变自己说话方式的影响,在与avatar聊天的实验中得到证明。

最后,张烨博士介绍了多种信息共现时多模态信息如何动态影响语言处理。由语言模型生成的诧异“surprisal”程度代表着信息的不可预期性,影响N400数值。而经过量化的上述手势、动作等多模态信息则可以调制诧异对于N400的影响,证明了多模态语言处理过程中人类会动态结合各种信息进行语义处理。此外还以二语使用者的实验为例,展示这一方法在具体语言信号处理问题上的运用。

回到ChatGPT,张烨博士也从语言学角度为大家简要分析了目前几种语言模型的差别,并分享了在单一模态(声音)与多模态(视频)情况下,不同语言模型(例如n-gram, GPT2)生成的诧异数值与N400拟合度的对比,展现不同语言模型对纯语言信息和多模态信息处理的差别,及其与人类信息处理方式的拟合程度。

同时她也指出,目前类似GPT4这样的模型已经可以识别和处理多模态信息,不仅作为整体理解,更可以借助训练理解图像内部的信息,以心理学中有名的“兔子/鸭子”图像为例。但也指出了现阶段的一些难题。对于GPT会不会有一张真实的“脸”,她认为很有可能,尤其对失语症患者等特殊人群、二语使用者、儿童等群体来说,如果GPT可以去捕捉更多的多模态信息,可以更有效地帮助他们进行语言沟通。同时这也面临着必要性、资源消耗、技术的不确定性、隐私和伦理等问题。

在精彩的分享结束后,现场的同学们踊跃发言,很多同学对AI使用、心理陪伴、语言处理有效性等与自己专业相关的问题进行了提问,和张烨博士展开了热烈地探讨。此次工作坊为同学们提供了一个初探语言学的窗口,并进一步展现了多学科交叉的潜能。本次活动参与学生近百名,反响积极热烈。